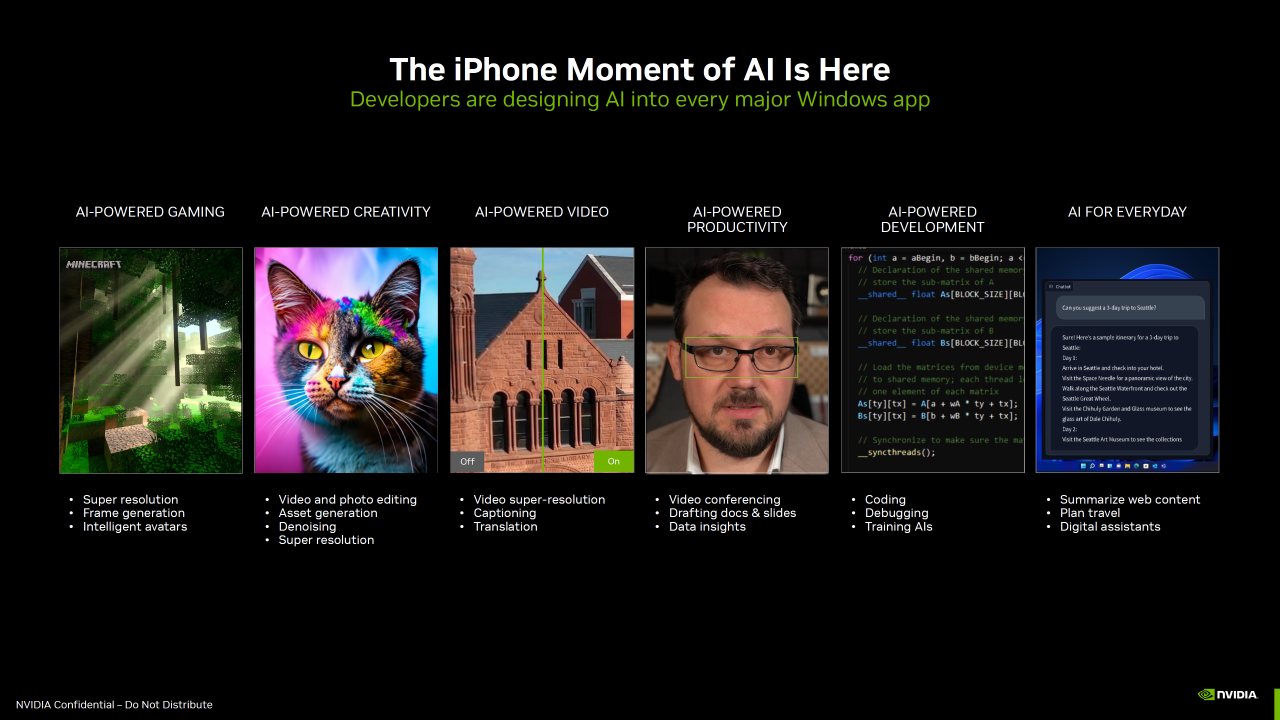

Nvidia omtaler det som “iPhone-øyeblikket” for AI.

Gjøres mulig med Nvidia TensorRT-LLM

Selskapet har nemlig annonsert at så lenge man har en RTX 30 eller 40 GPU med minst 8GB RAM, så vil de to nyeste generasjon skjermkort være i stand til å lokal-prosessere AI-oppgaver, og med mye bedre ytelse. De melder samtidig at “utviklere designer AI inn i hver eneste viktige Windows-app.”

Dette inkluderer selvsagt spill som allerede har super-oppløsning og Frame Generation, men også video-behandling som har vært på plass en stund, samt video-konferanser, oppsummering av nett-innhold, digitale assistenter og analysering av store datapakker.

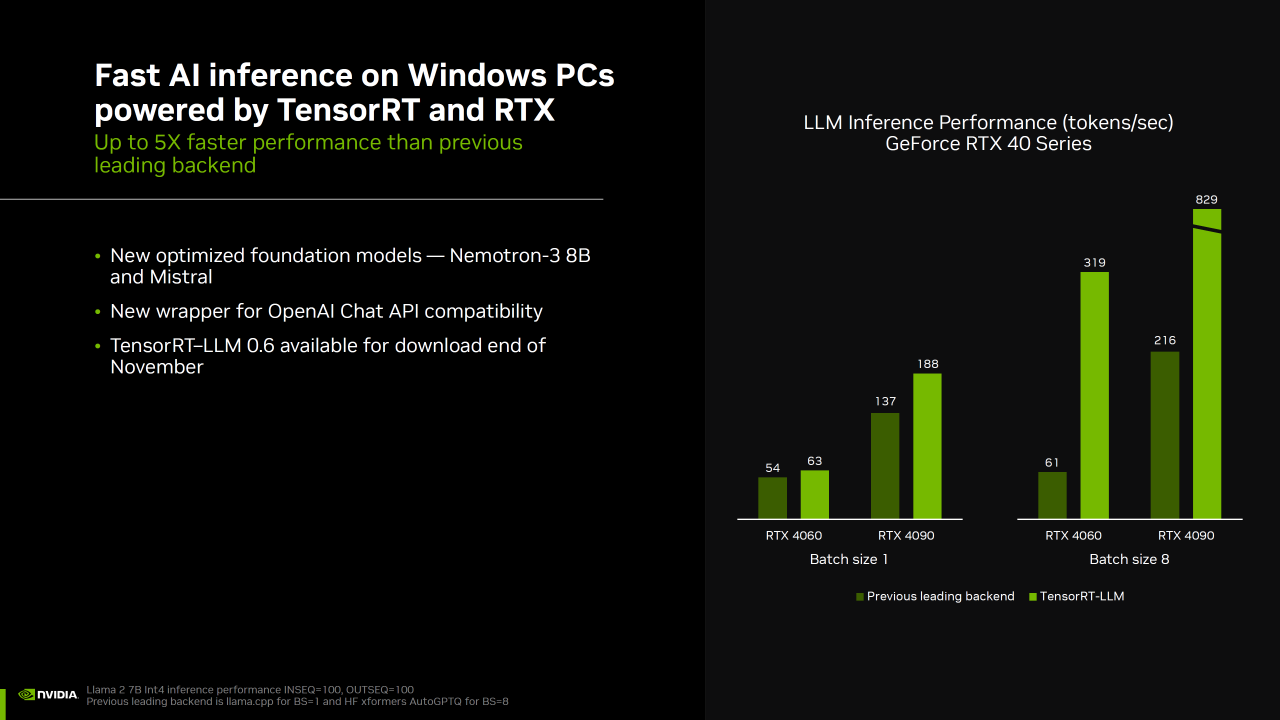

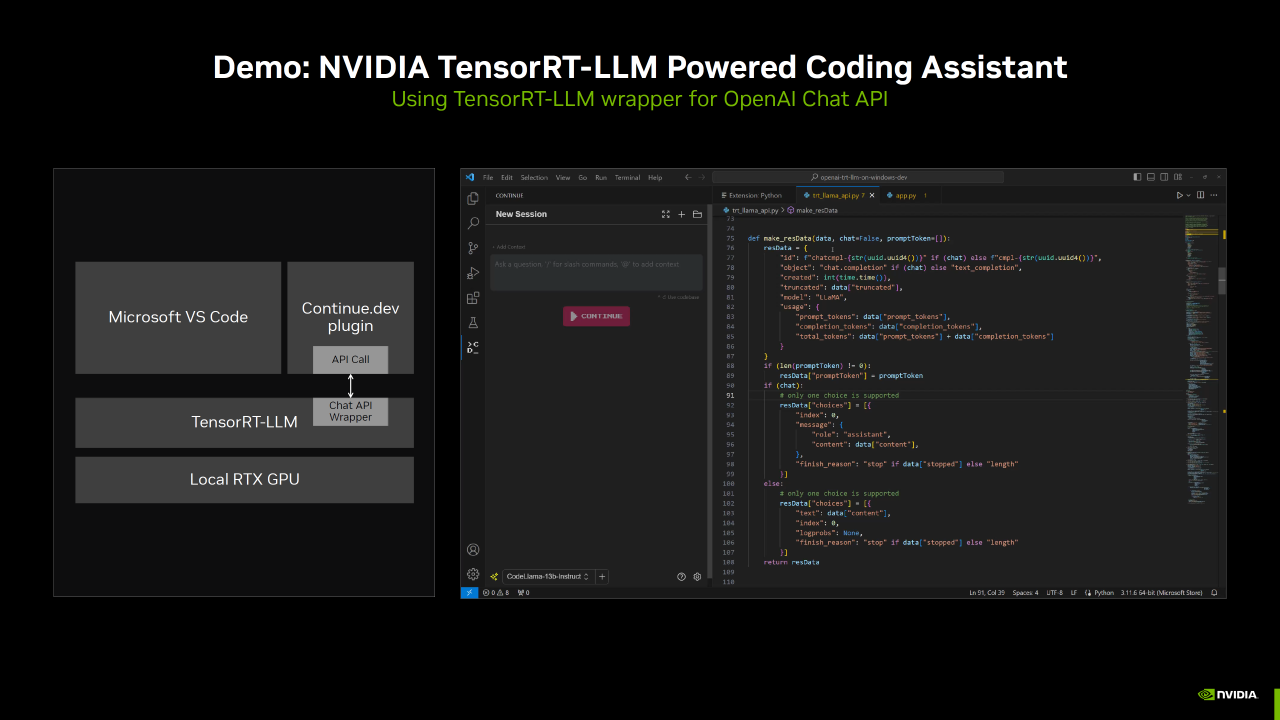

TensorRT-LLM for Windows vil snart være kompatibel med OpenAIs populære Chat API gjennom en ny wrapper. Dette vil gjøre det mulig for hundrevis av utvikler-prosjekter og applikasjoner å kjøre lokalt på en PC med RTX, i stedet for i skyen – slik at brukere kan beholde private og proprietære data på PC-ene sine.

Nvidia

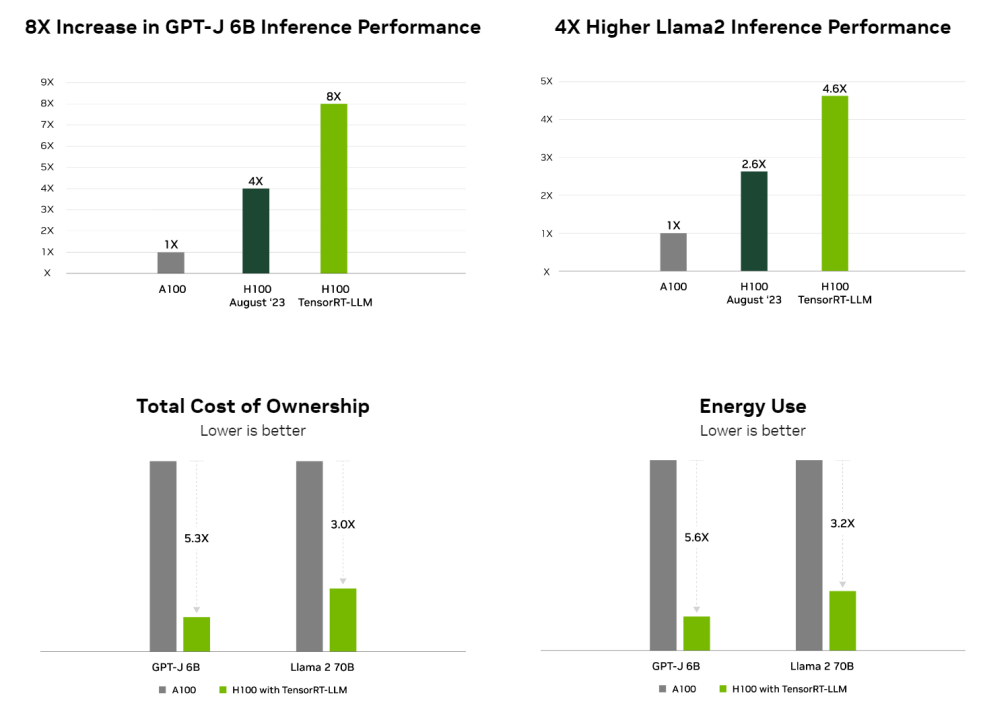

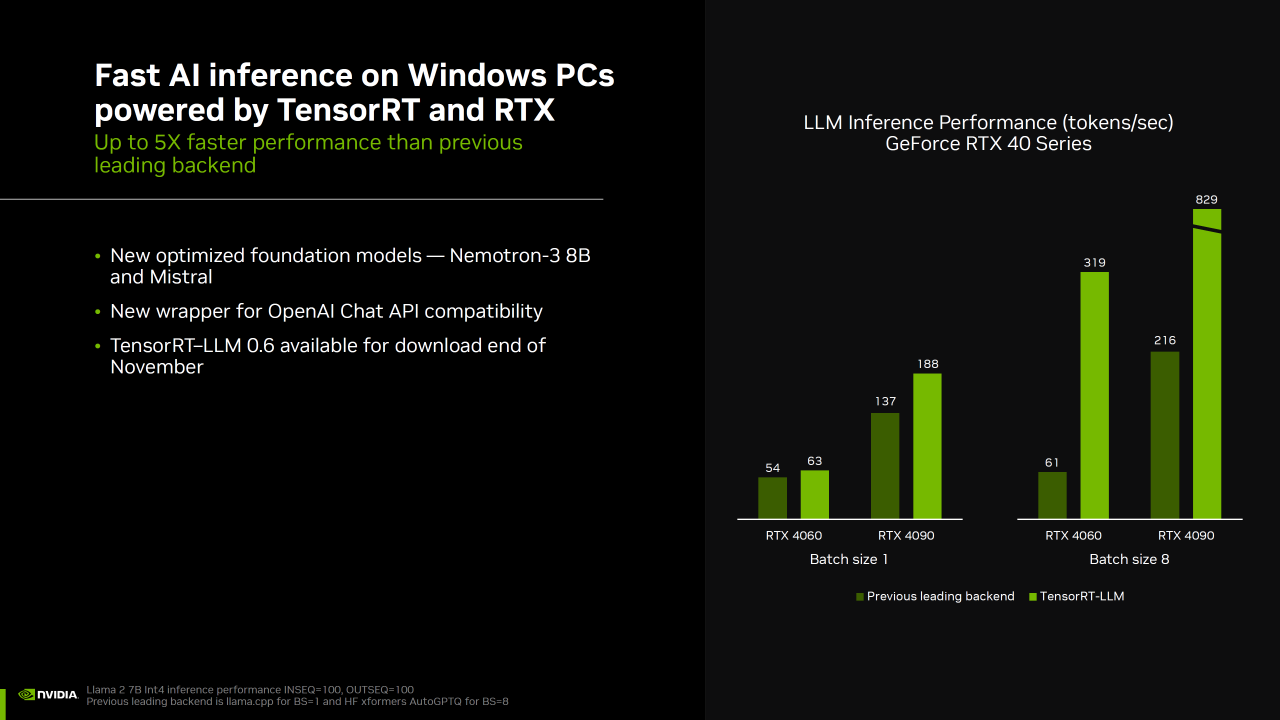

Ytelsen blir mye bedre

Nvidia skryter av fem ganger ytelses-forbedringer med TensorRT-LLM (last ned 0.5.0) i versjon 0.6.0 som lanseres senere denne måneden – det er denne som støtter RTX 30 og 40. Det blir også lagt til støtte for Mistral 7B og Nemotron 3 8B.

Den neste TensorRT-LLM-utgivelsen, v0.6.0 som kommer senere denne måneden, vil gi forbedret slutningsytelse – opptil 5 ganger raskere – og muliggjøre støtte for flere populære LLM-er, inkludert de nye Mistral 7B og Nemotron-3 8B. Versjoner av disse LLM-ene vil kjøre på hvilken som helst GeForce RTX 30-serie og 40-serie GPU med 8 GB RAM eller mer, noe som gjør raske, nøyaktige, lokale LLM-funksjoner tilgjengelige selv i noen av de mest bærbare Windows-enhetene.

Nvidia

Annonse