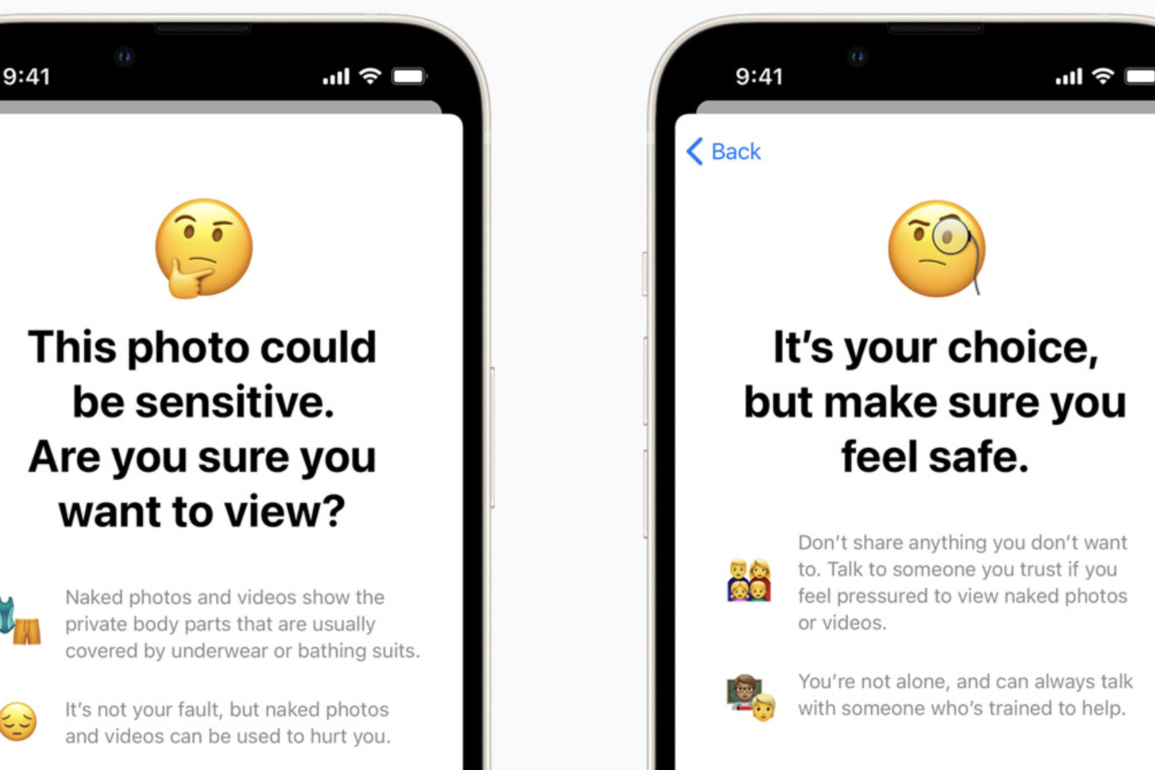

Apple stoppet midlertidig planene om å implementere bildescanning CSAM-teknologien i sine produkter for å stoppe barneporno etter massiv kritikk relatert til personvern og hvor nøyaktig teknologien egentlig er.

Oppdatert,

Til The Verge uttaler Apple at teknologien er utsatt og ikke kansellert.

Det kan se ut til at Apple dropper CSAM

Vi har ikke hørt noe om CSAM og Apples tilnærming til plattformen på lenge, og nå har selskapet i det stille fjernet alle henvisninger på sin nettside om sikker kommunikasjon.

Annonse

Følgende Apple-sitat fra 3. september 2021 er nå fjernet fra nettsiden:

Vi har tidligere kunngjort planer for funksjoner som er ment å beskytte barn mot kriminelle som bruker kommunikasjonsverktøy for å rekruttere og utnytte dem og for å begrense spredningen av materiale med seksuelt misbruk av barn. Basert på tilbakemeldinger fra kunder, fortalergrupper, forskere og andre, har vi bestemt oss for å bruke ekstra tid i løpet av de kommende månedene for å samle inn innspill og gjøre forbedringer før vi lanserer disse kritisk viktige barnesikkerhetsfunksjonene.

Apple

Vi følger utviklingen i saken og håper Apple klargjør sitt standpunkt.

Annonse