Forskere ved OpenAI, som forsker på maskinlæring, har ved hjelp av 100 år med simulert virtuell læring, lært en robot å rotere en terning.

Både fysisk og virtuell

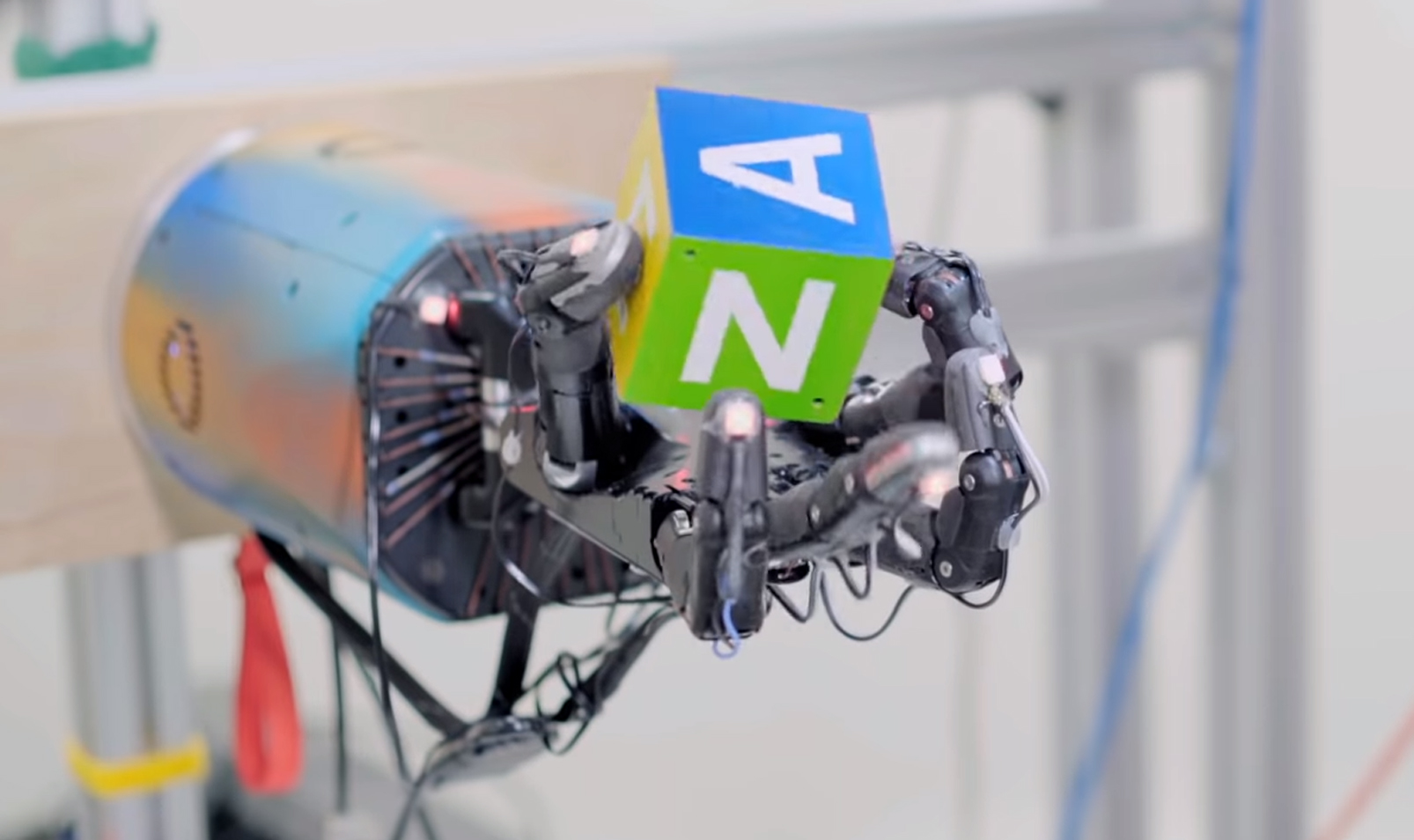

Roboten, som kalles Dactyl, eksisterer ikke bare i den virtuelle verdenen. Den er også en mekanisk hånd med fem fingre, trykksensorer og 24 graders bevegelsesfrihet (et menneske har 27 graders bevegelsesfrihet).

I en video som viser roboten i aksjon, både virtuelt og fysisk, får vi se roboten rotere en terning til den finner bokstaven eller fargen som blir spurt etter som er på terningens sider.

Annonse

Lærte seg teknikker brukt av mennesker

Over tid oppdaget og mestret roboten teknikker som ofte brukes av mennesker. Roboten begynte blant annet å holde fast terningen ved bruk av tommelen og lillefingeren, for så å bruke de andre fingrene til å rotere terningen.

Det interessante med denne forskningen, er at man har klart å overføre maskinlæring i en simulert verden, til en mekanisk hånd i den virkelige verdenen. Dette er i følge forskerne ikke en enkel prosess.

Faktorer i den virkelige verdenen skapte problemer

Problemet er at det er en stor avstand mellom det man får til i den simulerte verdenen sammenliknet med det man får til i den fysiske verdenen. I dette tilfellet fikk roboten (i den virkelige verdenen) til å utføre oppgavene, men den gjorde det markant dårligere enn i den simulerte verdenen. Som følge av gravitasjon, unøyaktigheter i mekanikken og andre faktorer som finnes i den virkelige verdenen, ble den ellers så nøyaktige robothånda rett og slett slepphendt.

100 år med maskinlæring

Opplæringssimuleringen, som sammenlagt hadde en varighet på over 100 år, ble gjort ved bruk av Rapid, et system med 384 maskiner som kjører en Proximal Policy Optimization-algoritme. Hver maskin lærte seg å rotere terningen i forskjellige scenarioer gjennom en datasimulering av robothånda.

Todelt nevralt nettverk

Treningssystemet benytter seg av et todelt nevralt nettverk. Den ene delen har ansvar for å ha styr på terningens posisjon, mens den andre delen forutsier hva slags belønning roboten får når den klarer oppgavene sine. Roboten har som mål å få så mange belønninger som mulig. Proximal Policy Optimization-algoritmen bruker deretter forsterkende læring slik at roboten lærer seg de beste teknikkene for å oppnå målene sine.

Forskerne håper at forskningen vil føre til lavere programmeringskostnader for roboter i fremtiden.

Kilde:

Annonse